通过 Ollama 部署 deepseek

2025年2月8日...大约 2 分钟

下载 DeepSeek

打开 Ollama 官网,点击顶部 Models 链接, 目前(2025-02-08) deepseek-r1 排行首位。

提示

由于电脑配置并不高,选择 1.5b 为演示版本(根据自己电脑和实际需求选择下载安装)。

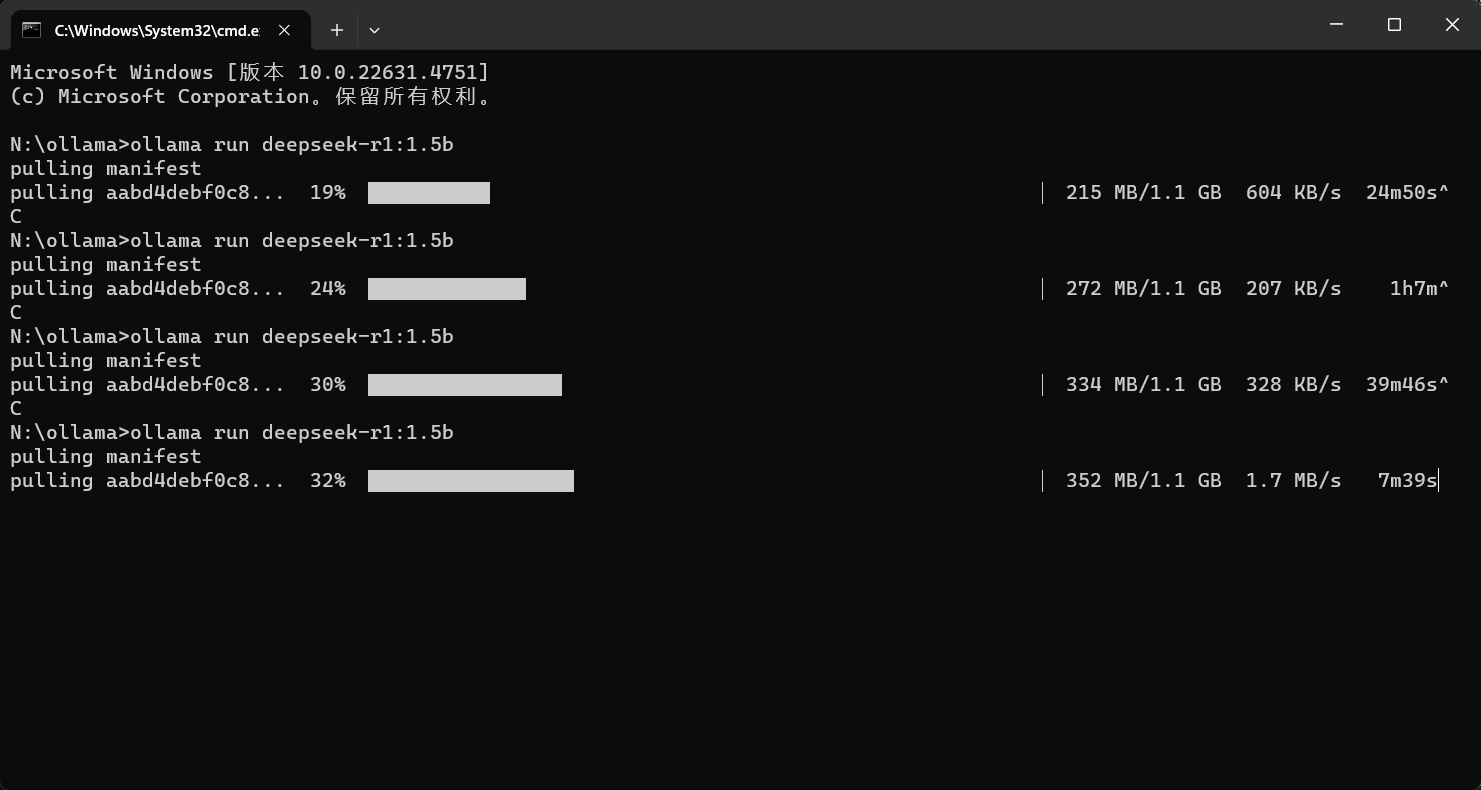

选择好模型后复制 ollama run deepseek-r1:1.5b 命令,在新的终端(CMD)窗口中执行

注意

命令要在新的 CMD 窗口中执行,因为在 自定义Ollama安装路径 中修改了大模型的存储位置, 如果不是新的 CMD 窗口,则下载的文件存储位置还在默认的 C 盘。

温馨提示

下载过程中速度可能降低,可以 Ctrl + C 中断下载,重新执行命令(极小概率会遇到重新下载的情况)。

验证 DeepSeek

在下载完成后,在 CMD 窗口中输入 ollama list,查看模型是否安装成功。

显卡要求

| 版本 | 显存需求 | GPU | 内存 | 适用场景 |

|---|---|---|---|---|

| DeepSeek-R1-1.5b | 约 6-8 GB | 单卡(如 NVIDIA RTX 3060、RTX 2080 Ti、A4000 等) | 16 GB | 小型任务,适合个人开发者或实验性研究。 |

| DeepSeek-R1-7b | 约 24-32 GB | 单卡(如 NVIDIA A100、RTX 3090、RTX 4090 等)或多卡并行 | 32 GB 或更高 | 中等规模任务,适合企业级应用或中等规模研究。 |

| DeepSeek-R1-8b | 约 32-40 GB | 单卡(如 NVIDIA A100)或多卡并行 | 64 GB 或更高 | 中等偏大规模任务,适合高性能计算环境。 |

| DeepSeek-R1-14b | 约 48-64 GB | 多卡并行(如 2-4 张 NVIDIA A100) | 128 GB 或更高 | 大规模任务,适合企业级高性能计算。 |

| DeepSeek-R1-32b | 约 128-160 GB | 多卡并行(如 4-8 张 NVIDIA A100) | 256 GB 或更高 | 超大规模任务,适合大型企业或研究机构。 |

| DeepSeek-R1-70b | 约 280-320 GB | 多卡并行(如 8-16 张 NVIDIA A100) | 512 GB 或更高 | 超大规模任务,适合顶级研究机构或超算中心。 |

| DeepSeek-R1-671b | 约 2.5-3 TB | 大规模多卡并行(如 32-64 张 NVIDIA A100 或 H100) | 2 TB 或更高 | 超大规模任务,适合国家级超算中心或顶级科技公司。 |

提示

数据信息由 DeepSeek 生成,仅供参考。